Pengertian Hadoop cara kerja,module dan sejarahnya – Dalam melakukan pengolahan data, khususnya Big Data, diperlukan sebuah software yang mampu melakukan pengolahan besar secara cepat. salah satu software yang bisa kita gunakan adalah apache hadoop. apa pengertian apache hadoop? bagaimana cara kerjanya? mari kita bahas.

Pengertian Hadoop

Apa itu Hadoop? pengertian Hadoop adalah sebuah framework yang memungkinkan anda untuk melakukan pengolahan data dengan ukuran yang sangat besar dengan menggunakan beberapa komputer sekaligus.

saat mulai belajar tentang big data, cepat atau lambat pasti anda akan mendengar istilah hadoop. jadi kurang rasanya jika kita tidak membahas tentang software ini.

baca : apa itu data science

Apa itu Hadoop

seperti yang saya katakan diatas, Hadoop adalah sebuah software yang memungkinkan anda untuk melakukan pengolahan data dengan ukuran yang sangat besar dengan menggunakan beberapa komputer sekaligus. hadoop bisa menghandle ribuan komputer sekaligus sehingga dapat saling terhubung dan tersingkronisasi.

Hadoop mengkoneksikan semua perangkatnya hingga ke layer aplikasi sehingga kita bisa membagi proses ke beberapa komputer sekaligus, bukan hanya penyimpanannya saja. misalnya saja kamu sedang melakukan training machine learning. maka proses training tersebut dibagi bagi ke beberapa komputer sama rata sehingga bisa berjalan lebih cepat.

baca: 14 tools data science terbaik selain hadoop

Module pada Hadoop

hadoop terdiri dari empat module utama, yang mana setiap modulenya melakukan pekerjaan penting untuk mengolah big data, diantaranya:

Hadoop Distributed File-System (HDFS)

Distributed file system memungkinkan anda untuk menyimpan data dengan cepat di tempat yang sudah ditentukan agar mudah untuk diakses.

seperti yang kita ketahui, hadoop bisa terdiri dari ribuan komputer sekaligus, oleh karena itu penting untuk mendistribusikan file dengan baik agar cepat untuk diakses. hal ini memungkinkan hadoop digunakan dalam data warehouse

Map Reduce

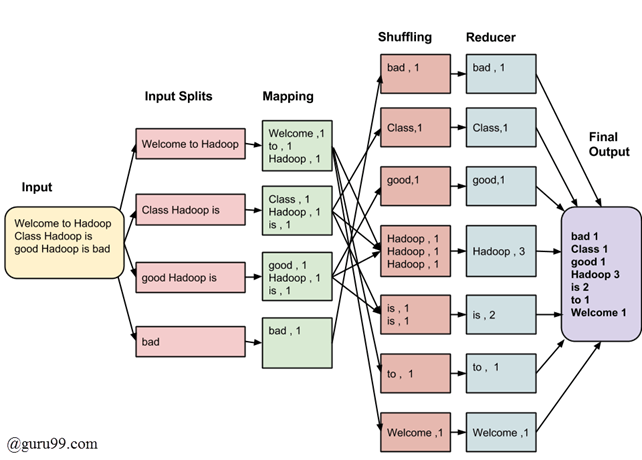

Map Reduce adalah sebuah teknologi yang digunakan pada saat pemrosesan data dalam jumlah besar. 2 kata utama pada module ini adalah map dan reduce.

map berfungsi untuk memilah data dan melakukan maping terhadap data tersebut. sedangkan reduce digunakan untuk mengurangi data yang tidak digunakan.

contoh penggunaan map reducer dapat dilihat dari gambar diatas, dimana kita akan menghitung semua kata pada input. hadoop akan memecah kata tersebut menjadi beberapa bagian agar bisa dikerjakan bersama sama.

Hadoop dapat menjalankan map reduce pada program yang ditulis dalam bahasa: Java, Ruby, Python, dan C ++.

map reducer akan sangat berguna bila data yang dikerjakan sangatlah banyak.

baca: apa itu manajemen data

Hadoop Common

Module ini akan menyediakan tools yang ditulis dengan bahasa java untuk user yang menggunakan sistem operasi konvesional seperti windows,mac,linux agar dapat membaca data yang berada di bawah hadoop.

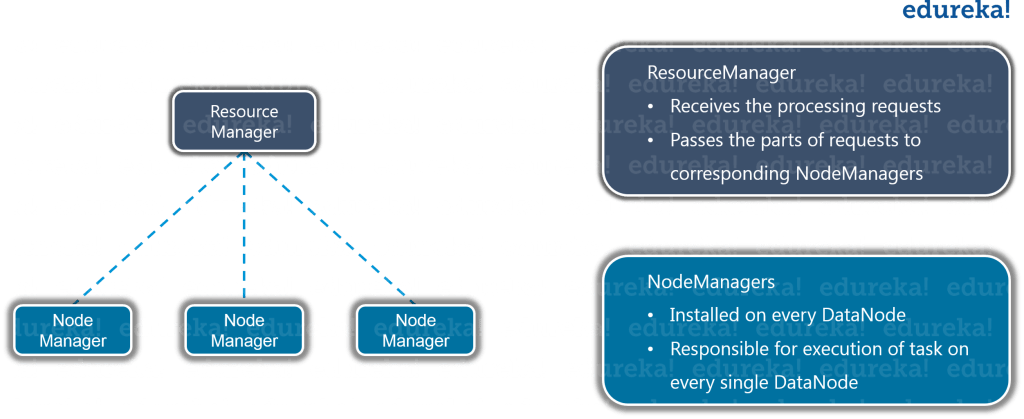

Yarn

Module yang terakhir adalah Yarn, Yarn sendiri berasal dari kata Yet Another Resource Negotiator. sebelumnya module ini dinamakan sebagai Map Reduce 2 karena kegunaanya yg hampir mirip,

module ini digunakan sebagai manajer segala sumber daya pada saat menyimpan dan menjalankan program. Yarn berada diantara HDFS dan Processing Engine. dan tugasnya adalah mengalokasikan segala resource yang dibutuhkan untuk menjalankan segala proses.

Sejarah Hadoop

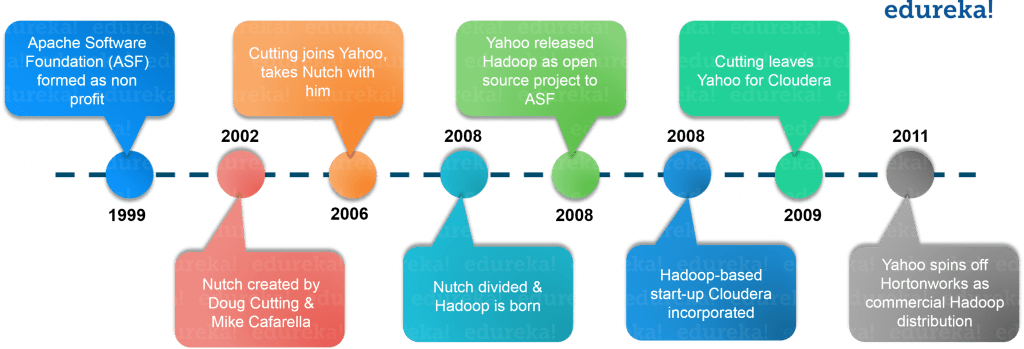

Pada tahun 2003, Doug Cutting meluncurkan proyek Nutch untuk menangani milyaran pencarian dan mengindeks jutaan halaman web. Kemudian pada Oktober 2003 – Google merilis makalah dengan GFS (Google File System). Pada Desember 2004, Google merilis makalah dengan MapReduce. Pada tahun 2005, Nutch menggunakan GFS dan MapReduce untuk melakukan operasi. Pada tahun 2006, Yahoo menciptakan Hadoop berdasarkan GFS dan MapReduce dengan Doug Cutting dan tim. Anda akan terkejut jika saya memberi tahu Anda bahwa, pada 2007 Yahoo mulai menggunakan Hadoop pada 1000 node cluster.

Kemudian pada Januari 2008, Yahoo merilis Hadoop sebagai proyek open source ke Apache Software Foundation. Pada Juli 2008, Apache berhasil menguji 4000 node cluster dengan Hadoop dengan sukses. Pada tahun 2009, Hadoop berhasil mengurutkan satu petabyte data dalam waktu kurang dari 17 jam untuk menangani milyaran pencarian dan mengindeks jutaan halaman web. Bergerak maju pada Desember 2011, Apache Hadoop merilis versi 1.0. Kemudian pada Agustus 2013, Versi 2.0.6 tersedia.

Ketika kami membahas tentang masalah, kami melihat bahwa sistem terdistribusi dapat menjadi solusi dan Hadoop menyediakan hal yang sama. Sekarang, mari kita pahami apa itu Hadoop.

sejarah dikutip dari edureka.co

Perusahaan yang sudah menggunakan hadoop

ada banyak sekali perusahaan besar yangsudah menggunakan hadoop, conothnya:

- Yahoo

- Amazon

- Zvents

- Yahoo

- AOL

- New York Times

- Eyealike

- Marks and Spencer

- Royal Mail

- Royal Bank of Scotland

- British Airways

- Expedia

- dll

baca : apache spark, big data platform terbaik

itulah beberapa hal yang dapat saya sampaikan mengenai Pengertian Hadoop cara kerja,module dan sejarahnya. semoga dapat menambah wawasan anda dalam bidang big data

Adinata is a tech expert and content creator experience more than 5 years on networking, coding and managed cloud vps server